En regardant les nouvelles fonctionnalités lancées par Google, on peut se demander à quels objectifs elles répondent: enrichir les services existants, ou préparer le terrain au lancement de nouveaux services, voire à de nouveaux usages de consommation ou à de nouvelles méthodes de distribution?

En regardant les nouvelles fonctionnalités lancées par Google, on peut se demander à quels objectifs elles répondent: enrichir les services existants, ou préparer le terrain au lancement de nouveaux services, voire à de nouveaux usages de consommation ou à de nouvelles méthodes de distribution?

Analyse de récents changements:

Nouvelles URL de referrers et AJAX

Prenons la nouvelle structure des URL de referrers des pages de résultats du moteur de recherche, décrite au détour d’un article expliquant que cela n’aura pas d’impact sur Google Analytics (si vous utilisez un autre service de tracking, pensez à demander). Les referrrers vont donc devenir plus complexes; plus riches en données exploitables, certes (avec le classement du lien cliqué par exemple), mais surtout plus complexes.

Quel intérêt de passer d’une structure très simple à quelque chose d’aussi compliqué? Tout simplement supporter le passage à une interface en AJAX, plus rapide et plus riche, qui déporte une partie des actions du serveur vers la machine de l’utilisateur.

L’intégration progressive d’AJAX permet à Google d’intégrer de plus en plus d’éléments riches dans les pages de résultats (tendance de fond depuis 2 ans: l’Universal Search). Par exemple, les tests de mars dernier sur un panel restreint d’utilisateurs ont montré de nouvelles fonctionnalités pour affiner les résultats, et ont révélé au passage la nouvelle structure d’URL de referrers. Passer à l’AJAX permet à Google de se renouveler, de continuer à innover, de lutter contre les velléités de la concurrence, et tout ça sans avoir à subir une hausse des coûts.

En effet, l’AJAX a comme avantage secondaire et non négligeable de réduire la charge serveur, ce qui permet d’obtenir une baisse des coûts serveurs, ou une capacité à lancer de nouvelles fonctionnalités à périmètre serveurs constant. L’AJAX est d’ailleurs une technologie mature chez Google, notamment via Gmail, pour lequel ils ont plusieurs fois réécrits des portions importantes de javascript.

Gears et gestion asynchrone

Incorporer des technologies AJAX va pourtant à l’encontre de la simplicité traditionnellement promue par Google: en effet, quoi de plus rapide que la version HTML basique de leurs pages de résultats? Les résultats riches et les fonctionnalités AJAX nécessitent de télécharger bien plus d’éléments, et la charge serveurs s’en trouve alourdie… au premier téléchargement. Ensuite, le cache du navigateur et le processeur de la machine de l’utilisateur tâchent d’en faire le plus possible sans recourir au serveur. Dans un second temps, les performances peuvent encore êtres améliorées grâce à Gears, une extension pour navigateurs qui améliore l’interaction web/local en stockant et exécutant une partie du code et des informations habituellement gérées par le serveur; un mini-serveur local, en somme.

Gears permet par exemple d’accélérer la rédaction des articles sur ce blog dans WordPress, ou de gérer ses mails Gmail en mode offline.

Quelle application de Gears peut-on imaginer pour les pages de résultats de recherche? Le maintien de la rapidité d’affichage, composante importante de la qualité et de la pertinence perçue par les utilisateurs, tout en augmentant les fonctionnalités offertes au sein des pages de résultats. (Ce qui se renforce d’encore un cran au sein de Chrome, le navigateur de Google dont le moteur javascript a été fortement optimisé pour accélérer les applications web comme… Gmail, et probablement l’ensemble des services Google.)

Une fois l’ensemble de ces techniques maîtrisé, n’importe quel service peut être adapté à cette logique web/local asynchrone, fluide et légère, et les nouveaux services ou produits Google ne devraient pas manquer d’apparaître.

Néanmoins, ces nouvelles fonctionnalités n’ont pas que l’enrichissement de l’offre comme objectif, mais aussi l’accès à cette offre au travers de nouveaux appareils et de nouveaux modes de consommation.

Une chaîne plus fluide: pour les appareils légers

L’AJAX et Gears facilitent l’accès à l’ensemble des services Google « in the cloud » depuis n’importe quel appareil, mais surtout depuis les appareils « SCF« : téléphones mobiles, netbooks, etc. Vous pouvez de plus en plus utiliser les services sans être nécessairement connecté, et sans en avoir à vous en soucier: le mail partira lorsque votre téléphone aura récupéré une connexion au sortir de l’immeuble, ou bien l’article sera publié lorsque votre train sera sorti du tunnel. L’expérience est fluide et transparente.

D’ailleurs, plus besoin d’utiliser une machine puissante dotée d’un système d’exploitation ou d’un navigateur classique, un appareil basique suffit, dont la puissance, le système d’exploitation et le navigateur sont allégés et mélangés, à l’exemple de l’iPhone, ou des terminaux Android, téléphones ou netbooks.

En somme, les nouvelles fonctionnalités de Google leur permettent de capitaliser sur et de continuer à développer la puissante capacité technique à leur disposition, que ce soit en termes de capacité serveurs ou en bande passante, et le lancement de nouveaux services peut se faire de façon de plus en plus transparente, voire anodine, sans investissements conséquents (le rêve de l’actionnaire).

N.B. Pour ceux qui n’auraient pas suivi, Google est principalement une architecture réseau et technique d’une dimension sous-estimée, capable, entre autres choses, de gérer un moteur de recherche rentable.

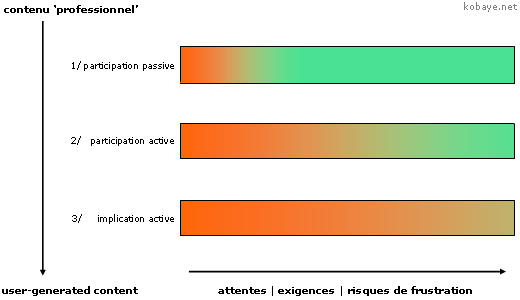

Lors de la conférence « Comment les entreprises s’organisent pour tirer parti du mode de vie et de travail des générations Internet? » aux

Lors de la conférence « Comment les entreprises s’organisent pour tirer parti du mode de vie et de travail des générations Internet? » aux

Dans Synthetic Worlds: The Business And Culture Of Online Games,

Dans Synthetic Worlds: The Business And Culture Of Online Games,