Dans La fin de la télévision, Jean-Louis Missika décrypte les évolutions du monde de la télévision de son invention à nos jours, et explique comment la télévision va disparaître, à l’heure où les écrans et les images sont omniprésents.

Dans La fin de la télévision, Jean-Louis Missika décrypte les évolutions du monde de la télévision de son invention à nos jours, et explique comment la télévision va disparaître, à l’heure où les écrans et les images sont omniprésents.

—

Une présentation chronologique des évolutions de la télévision permet à l’auteur de montrer le déclin de la dimension éditoriale de la télévision et la perte d’influence de ceux qui véhiculent ces messages: chaînes, présentateurs et animateurs en tous genres. En effet, selon Jean-Louis Missika, des années 1950 aux années 1980/90, on est passé d’un univers dans lequel la télévision était une institution de transfert de savoirs et de connaissances, fortement contrôlée par les pouvoirs en place (la paléo-télévision), à une télévision de plus en plus proche du téléspectateur, dans laquelle ce dernier s’invite à l’écran (la néo-télévision). L’évolution s’est poursuivie avec l’apparition d’une télévision encore plus proche du téléspectateur, fusionnelle, dans laquelle seul compte le fait d’être à la télévision (la post-télévision). En conséquence, il est maintenant plus important de coller aux attentes et émotions du public que de faire passer des messages.

Comment en est-on arrivé là? Ces changements ont-ils été imposés par les chaînes de télévision, ou bien la télévision a-t-elle accompagné un ensemble de mutations inévitables?

—

Selon Jean-Louis Missika, trois fais expliquent ces glissements: la démédiation, la dépendance, et la déprofessionnalisation.

La démédiation est pour la télévision la perte progressive de son statut d’acteur économique incontournable. Quand des centaines de chaînes sont accessibles par ondes hertziennes, par câble, ou par satellite, l’offre devient hyper-segmentée, et en conséquence, l’audience se fractionne. Ce fractionnement pénalise les grandes chaînes (sans pour autant conforter la situation des petites) dans la course à l’audience, nécessaire pour négocier aussi bien avec les producteurs de contenus que les annonceurs.

Dans le même temps, les producteurs de contenus ont revu leurs positions en capitalisant sur leurs compétences-clés et sont dorénavant dans une situation de force par rapport aux chaînes, créant pour la télévision une situation de dépendance. Un exemple? La Champion’s League, événement international, a noué un partenariat avec Playstation, partenariat que les (nombreuses) chaînes de télévision doivent accepter afin d’obtenir les droits de retransmission de l’événement.

Ce phénomène de dépendance est renforcé par l’apparition de supports concurrents de la télévision: des acteurs comme les FAI ou les portails web sont en mesure de concurrencer les chaînes de télévision dans les négociations avec les producteurs de contenus: les FAI disposent d’une audience captive (leurs bases d’abonnés), et les portails web disposent d’une audience massive, couvrant souvent plusieurs pays.

Au passage, le contexte de convergence numérique accentue également l’hyper-segmentation de l’offre en permettant aux producteurs d’événements de diffuser directement leurs contenus, grâce à de nouveaux moyens de diffusions comme la TV IP ou le podcasting, qui s’ajoutent aux diffusions par câble, satellite, TNT, etc. Certains clubs de football gèrent ainsi la diffusion de leurs matchs au travers de chaînes spécifiques sur la câble ou le satellite (Barça TV ou OM TV), voire en ligne (OM TV online).

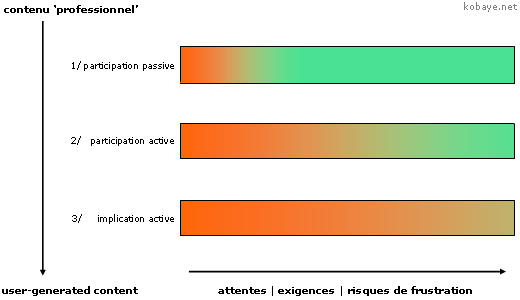

De l’autre côté du téléviseur, la prise de participation croissante des téléspectateurs dans les activités médias crée un phénomène de déprofessionnalisation de la télévision. Le phénomène de création personnelle de vidéos n’est certes pas nouveau; ce qui est nouveau, c’est la capacité de diffusion qui s’offre à tous ces vidéastes amateurs. YouTube ou DailyMotion sont les premiers vecteurs de la conquête de l’espace audiovisuel par les téléspectateurs. Bien entendu, seule une minorité d’individus va diffuser activement des contenus vidéo en ligne. Néanmoins, cela suffira pour accentuer les phénomènes déjà à l’oeuvre: diminuer l’importance des chaînes de télévision du fait d’une fragmentation extrême de l’audience, et renforcer l’idée que se font les personnes de l’accès à l’antenne: un droit en soi.

—

Dans la troisième et dernière partie de son ouvrage, Jean-Louis Missika explique en quoi la disparition progressive de la télévision est négative sur le plan social: la fin de la télévision entraîne la disparition du principal espace de débat. La télévision est (était?) le meilleur forum des sociétés démocratiques modernes: elle favorise l’échange d’idées, et permet à chacun d’affiner ses propres idées, en se confrontant à l’ensemble des opinons.

En effet, la télévision, encore mieux que la radio ou la presse, permet de matérialiser la confrontation, par exemple à l’occasion d’un débat politique entre deux candidats à l’investiture présidentielle, et de rassembler une audience massive devant ce débat.

Le passage de la paléo-télévision à la néo-télévision a diminué l’importance accordée à ces événements, en décrédibilisant les porteurs de messages à l’écran et en offrant la possibilité aux téléspectateurs de se tourner vers des programmes plus consensuels ou plus en accord avec leurs goûts. Le passage à la post-télévision a quant à lui fini d’enfoncer le clou, avec la perte totale d’intérêt accordé aux messages diffusés.

L’auteur prend la campagne présidentielle française de 2002 comme exemple, durant laquelle l’ensemble de l’électorat s’est désintéressé de l’événement. Le choc du 21 avril a ainsi abouti à une situation absurde: la campagne a duré à peine quelques minutes, entre l’annonce des résultats du premier tour à 20 heures et les réactions qui ont suivi. Au final, il n’y aura eu quasiment aucun échange ou débat politique réel pour cette élection présidentielle, et les transformations de la télévision y sont pour beaucoup: décrédibilisation des porteurs de messages, simplification extrême des messages en eux-mêmes, et focalisation sur l’humain et ses bassesses plutôt que ce qui est dit.

—

Comme l’indique le quatrième de couverture: Nous entrons dans un monde d’images omniprésentes et de média absent. Toujours plus d’images et toujours moins de télévision. Nous allons connaître une société sans télévision. Le point clé de la disparition de la télévision étant, selon l’auteur, la perte d’un espace d’échange d’idées, politiques, sociales ou autres. La fin de la télévision intervient sans que rien n’émerge en remplacement. Il reste donc à inventer un nouveau forum de discussion public, ouvert, et massif. Rapidement, si possible.

—

La fin de la télévision, par Jean-Louis Missika: un essai convaincant sur les mutations des médias audio-visuels et la disparition programmée de la télévision en tant que média éditorial incontournable, publié à La République des Idées, chez Seuil.

Pour acheter ce livre sur amazon.fr, cliquez ici: La fin de la télévision .

.

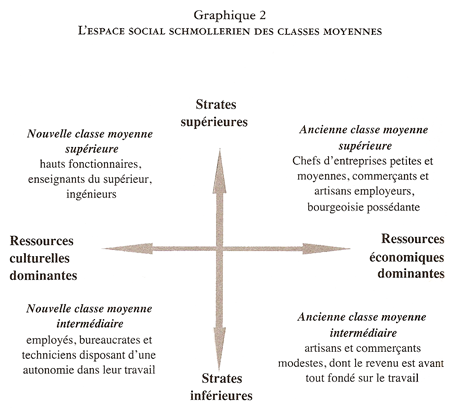

Dans Les classes moyennes à la dérive, Louis Chauvel analyse la situation des classes moyennes en France, sous l’angle économique, social et historique. Un éclairage douloureux mais nécessaire.

Dans Les classes moyennes à la dérive, Louis Chauvel analyse la situation des classes moyennes en France, sous l’angle économique, social et historique. Un éclairage douloureux mais nécessaire.

Dans La fin de la télévision, Jean-Louis Missika décrypte les évolutions du monde de la télévision de son invention à nos jours, et explique comment la télévision va disparaître, à l’heure où les écrans et les images sont omniprésents.

Dans La fin de la télévision, Jean-Louis Missika décrypte les évolutions du monde de la télévision de son invention à nos jours, et explique comment la télévision va disparaître, à l’heure où les écrans et les images sont omniprésents.

Dans Synthetic Worlds: The Business And Culture Of Online Games,

Dans Synthetic Worlds: The Business And Culture Of Online Games,