Contrepoint du livre « Les classes moyennes à la dérive » de Louis Chauvel, Les nouvelles classes moyennes de Dominique Goux et Eric Maurin présente une situation optimiste, ou tout du moins stable pour les catégories de population situées entre les deux extrêmes de l’échelle sociale. Difficiles à définir, les auteurs tentent une première approche en traçant un périmètre, au travers de trois visages des classes moyennes:

Contrepoint du livre « Les classes moyennes à la dérive » de Louis Chauvel, Les nouvelles classes moyennes de Dominique Goux et Eric Maurin présente une situation optimiste, ou tout du moins stable pour les catégories de population situées entre les deux extrêmes de l’échelle sociale. Difficiles à définir, les auteurs tentent une première approche en traçant un périmètre, au travers de trois visages des classes moyennes:

- acteurs pugnaces de la compétition sociale

- centre de gravité de la société

- arbitres politiques

Le périmètre défini par ces trois visages permet de mieux comprendre de quels groupes les auteurs parlent, et insiste sur l’importance qu’ils confèrent aux classes moyennes pour l’ensemble de la société.

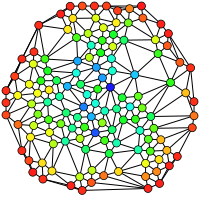

Ces classes moyennes sont également définies par leur position centrale dans les flux de personnes entre les différentes strates de l’échelle sociale: à la fois lieu de transition, de développement mais aussi de dépérissement, et réservoir pour les extrêmes de l’échelle. Les classes moyennes sont dynamiques, tant en leur sein – entre les classes moyennes inférieures et supérieures, entre les cadres et les employés – que dans leurs rapports avec les classes supérieures et inférieures.

Ainsi, les auteurs mesurent à la fois un accroissement des échanges: « deux fois plus intenses aujourd’hui qu’ils ne l’étaient il y a seulement vingt ans » et de la population concernée: « au cours des dernières décennies, la proportion de Français qui se déclarent appartenir aux classes moyennes a d’ailleurs été multiplié par deux » (page 12). Pour Dominique Goux et Franck Maurin, les classes moyennes se sont développées, quantitativement et qualitativement.

En effet, comme l’indique la définition de l’historien Serge Bertsein citée page 17, les classes moyennes se caractérisent par « une philosophie sociale où le progrès résulterait non d’une dialectique de lutte des classes, mais de possibilités de promotion« . La dynamique – quelle soit réelle ou simple potentialité – est donc clé.

Cette dynamique de promotion a-t-elle été réelle et bénéfique? Les classes moyennes sont-elles encore en progression? Les auteurs répondent positivement, bien que la réalité ne soit pas si positive que cela. Certes, les classes moyennes se sont développées, mais le sentiment de (peur du) déclassement est là. Une explication intéressante avancée par Dominique Goux et Franck Maurin tient au fait de l’évolution quantitative des différentes catégories, aussi bien dans l’ensemble de la société qu’au sein des classes moyennes. Par exemple, le salariat intermédiaire n’a pas reculé dans sa position relative aux classes supérieures. « Simplement, du fait de l’expansion quantitative des cadres au détriment des ouvriers, il se place juste au-dessus de la médiane de la distribution des salaires, plutôt que juste au-dessous du premier quart, occupant bien plus précisément qu’autrefois le point d’équilibre du salariat. Les dernières décennies n’ont pas été celles d’une régression des catégories intermédiaires dans la société, mais celles d’un rééquilibrage général de l’ensemble de la structure sociale autour de ce groupe de plus en plus vaste et central. » (page 46)

Cette massification des classes moyennes pose également des problèmes d’ordre qualitatifs: les situations se durcissent car les investissements consentis par les familles pour progresser, ou tout simplement pour se maintenir, doivent être croissants; tenir le rang dans les compétitions scolaire, géographique (entre quartiers riches/pauvres) et socio-économique en général n’a pu se faire qu’en engloutissant des sommes, efforts et sacrifices toujours plus grands, au travers de stratégies de plus en plus complexes (et épuisantes/incertaines dans la durée).

Pour Dominique Goux et Eric Maurin, la société française n’est pas encore bloquée, et une dynamique sociale positive peut être lancée. Je retiens principalement leur idée d’un « retour à des programmes moins explicitement ciblés sur des publics particuliers, l’action de l’Etat devant créer de la continuité et de la mobilité dans la société plutôt que des effets de seuil, des clivages et des statuts. » En effet, les aides ciblées sur des groupes ou géographies précis, même quand elles ne sont pas inefficaces, marquent leurs bénéficiaires comme « privilégiés » dans les yeux des autres et contribue à « accroître encore le sentiment d’injustice à l’égard des dispositifs de redistribution« . (pages 116 et 117)

Ce constat de la difficulté croissante va plutôt dans le sens de Louis Chauvel: qu’il soit réel ou simplement perçu, le sentiment de déclassement est là, et mine les esprits – la perception étant la réalité.

Pour acheter Les nouvelles classes moyennes de Dominique Goux et Eric Maurin sur amazon.fr, cliquez ici: Les nouvelles classes moyennes.

—

Pour aller plus loin, il est intéressant de consulter l’article Classes moyennes : peurs infondées ou réelles difficultés? de Louis Chauvel sur le site de l’OFCE, dans lequel il présente sa note Les raisons de la peur : Les classes moyennes sont-elles protégées de la crise ? Il reprend les deux thèses opposées – celle de Dominique Goux et Eric Maurin, positive, et la sienne, pessimiste – et insiste sur une dégradation de la situation relative des classes moyennes, dégradation illustrée par le graphique Rapport entre le salaire annuel à temps plein net des professions intermédiaires et celui des ouvriers/ouvrières. L’appauvrissement relatif de membres des classes moyennes par rapports aux classes inférieures est clair: le rapport entre les salaires de ces deux catégories chute de plus de 2 durant les Trente Glorieuses à ~1,5 depuis les années 2000. Comme Louis Chauvel le précise:

Le niveau de vie relatif des classes moyennes intermédiaires a connu son apogée à la fin des Trente glorieuses: depuis la fin de cet âge d’or, la stagnation des salaires et des revenus, la réduction des écarts salariaux avec les classes populaires en emploi (voir le graphique), le risque inédit de chômage, l’expansion numérique des diplômes située très au-delà des places disponibles dans les professions intermédiaires, le déclassement scolaire qui s’ensuit, etc. ont été autant de dimensions problématiques analysées dans cette note soulignant l’existence d’un malaise bien réel.

Deuxième partie du recueil Lutter contre la pauvreté d’

Deuxième partie du recueil Lutter contre la pauvreté d’

Recueil de textes pour la plupart publiés dans le journal Le Monde entre novembre 2005 et avril 2006, la nouvelle critique sociale (la république des idées) regroupe une dizaine d’auteurs. L’idée est de présenter de nouvelles lectures pour analyser la société (française), car apparemment, les prismes classiques ne parviennent plus à décrire ni les situations actuelles économique, sociale, démographique… ni les évolutions.

Recueil de textes pour la plupart publiés dans le journal Le Monde entre novembre 2005 et avril 2006, la nouvelle critique sociale (la république des idées) regroupe une dizaine d’auteurs. L’idée est de présenter de nouvelles lectures pour analyser la société (française), car apparemment, les prismes classiques ne parviennent plus à décrire ni les situations actuelles économique, sociale, démographique… ni les évolutions. En regardant les nouvelles fonctionnalités lancées par Google, on peut se demander à quels objectifs elles répondent: enrichir les services existants, ou préparer le terrain au lancement de nouveaux services, voire à de nouveaux usages de consommation ou à de nouvelles méthodes de distribution?

En regardant les nouvelles fonctionnalités lancées par Google, on peut se demander à quels objectifs elles répondent: enrichir les services existants, ou préparer le terrain au lancement de nouveaux services, voire à de nouveaux usages de consommation ou à de nouvelles méthodes de distribution? Dans Le capitalisme est-il moral?, livre issu d’une série de conférences qu’il a données sur ce thème, André Comte-Sponville propose une grille de lecture permettant de dire si le capitalisme, système économique dominant sans partage depuis la fin du bloc soviétique et l’ouverture de la Chine, est moral.

Dans Le capitalisme est-il moral?, livre issu d’une série de conférences qu’il a données sur ce thème, André Comte-Sponville propose une grille de lecture permettant de dire si le capitalisme, système économique dominant sans partage depuis la fin du bloc soviétique et l’ouverture de la Chine, est moral.

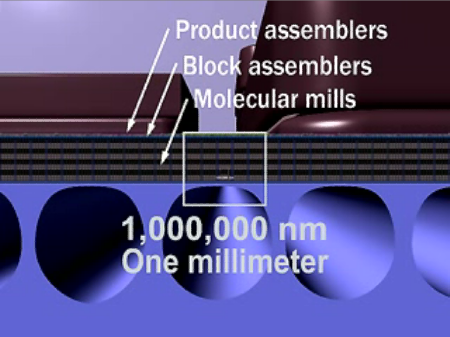

Lors de la conférence « Comment les entreprises s’organisent pour tirer parti du mode de vie et de travail des générations Internet? » aux

Lors de la conférence « Comment les entreprises s’organisent pour tirer parti du mode de vie et de travail des générations Internet? » aux